A webhely új, emiatt próbaidőn van a Google-nél

Az első számú probléma, amely a nagy visszaesések kapcsán tapasztalható, általában az új webhelyeket érinti. A néhány hónapnál nem régebbi site-okkal ugyanis a Google kapcsolata bonyolult: egy ideig nagyon szereti őket, egy idő után pedig nagyon nem.Közvetlenül az indulást követően a Google egyáltalán nem fog tudni a site-ról addig, amíg az oldalak indexelése – a Google adatbázisba vétele – nem történik meg. Mindaddig a webhely nem jelenik meg a keresési eredmények között.

Miután a site indexelése megtörtént, a Google gyakran „megtolja” egy kicsit a webhely rangsorolását, tehát jobb pozíciókat kölcsönöz neki, mint amilyeneket megérdemelne. Ezzel az átmeneti előnyben részesítéssel a kereső célja az, hogy láthatóvá tegye a felhasználók számára az új webhelyet. Így jobban megértheti a site által kiváltott felhasználói viselkedést. (Ha például a Google azt látja, hogy a látogatók gyorsan lepattannak, tudni fogja, hogy az oldal nem megfelelő minőséget képvisel.) A mesterséges pozíciójavítás következtében könnyű azt hinni, hogy a webhely saját jogán érte el a helyezést. Azonban az átmeneti időszakot követően a weboldal visszaesik, ha a minősége nem megfelelő.

A webhely csak néhány rangsorolási tényezőre összpontosít

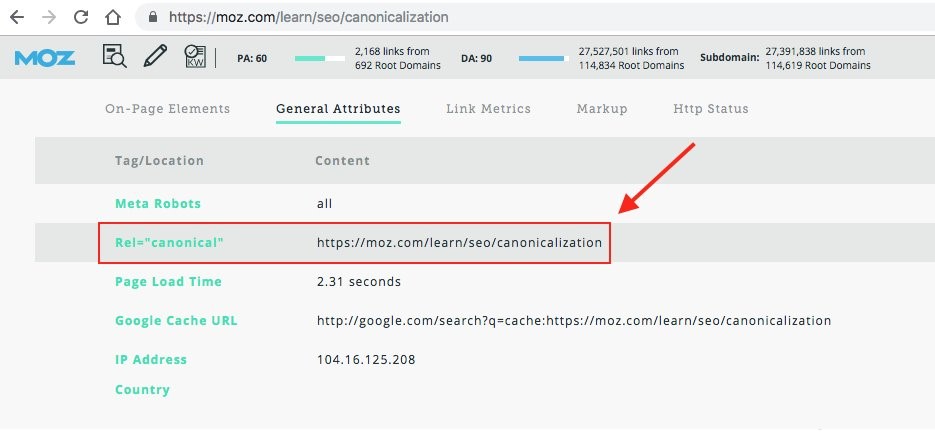

A rangsorban elért pozíciók drasztikus romlásának második leggyakoribb oka, amikor csak egy-két rangsorolási tényezőre koncentrál az oldal. Vagyis a többi faktorról nem hajlandó tudomást venni. Holott a stabil, hosszú távon fenntartható jó helyezés kulcsa, hogy a site minél többféle rangsorolási tényezőt figyelembe véve szálljon versenybe. Tegyük fel, a SEO erőforrások a webhely visszamutató hivatkozásainak építésére koncentráltak a minőségi tartalom vagy a gyorsan betöltődő honlap rovására. Ha valóban erről van szó, a hirtelen pozícióvesztés bekövetkeztének valószínűsége jelentős.Kanonizálási problémák miatt a Google ismétlődő tartalmakat lát a site-on

Tegyük fel, egy oldal több URL-en is elérhető, vagy több verzió – például http illetve https protokoll – alatt is indexelve lett. Ebben az esettben a Google nehezen tudja eldönteni, hogy az oldal melyik változatát jelenítse meg a találati listán. Ezért végül, mint duplikált tartalmat, egyik verziót sem jeleníti meg. A kanonikus URL (gyűjtő URL) beállításával azonban könnyen orvosolható a probléma. A megoldás segítségével a webmesterek kijelölhetnek – kanonizálhatnak – egy-egy oldalt, melyet a Google mint fő verziót jelenít meg a találatok között. Ezzel a duplikált tartalmak okozta pozícióromlás megelőzhető. Igen ám, de ha a site-ra hivatkozó külső webhelyek a nem kanonizált oldalra hivatkoznak, az megint csak elbizonytalaníthatja a Google-t. Melyik oldalt szeresse? Ilyenkor érdemes felvenni a kapcsolatot a hivatkozó site webmesterével, és rávenni őt arra, hogy a kanonizált oldalra mutató linkkel hivatkozzon.

Szerverproblémák miatt hosszabb idejű leállásokat produkál az oldal

A Google meglehetősen elnéző a rövid ideig tartó szerverproblémákkal kapcsolatban. Ha a webhely karbantartás miatt áll, vagy egy-két napig elérhetetlen, az a rangsorolást nem befolyásolja. Ha azonban a keresőmotor több napig nem tud hozzáférni webhelyhez, az negatív hatással lehet a helyezésékre. Ezért, ha előre tervezett karbantartásra kerül sor, érdemes 503-as kód elhelyezésével tájékoztatni a Google-t arról, hogy a kimaradás átmeneti.Rosszindulatú (malware) programok jelenlétét észleli a Google a site-on

Bár a malware webhelyen való jelenléte közvetlenül nem rontja a rangsorolást, az előkelő helyezésekből származó forgalom nagyságára jelentős hatást gyakorolhat. Ha ugyanis a Google rosszindulatú programok jelenlétét észleli egy webhelyen, ezt a tényt nem tartja meg magának. Hanem a találati listán jól látható módon figyelmeztetést jelenít meg erről a felhasználók számára. Emiatt pedig a userek nagy valószínűséggel le sem kattintják az oldalt. Szerencsére több különböző eszköz is rendelkezésre áll, melyek segítségével ezen rosszindulatú programok detektálhatók és eltávolíthatók. Ha a fertőzés-mentesítés sikeresen megtörténik, a Google megszünteti a rosszindulatú programok jelenlétére utaló figyelmeztetést, így az elvesztett forgalom hamar visszaszerezhető.Az algoritmus-frissítések következményei nem kívánt hatást gyakorolnak az oldal helyezéseire

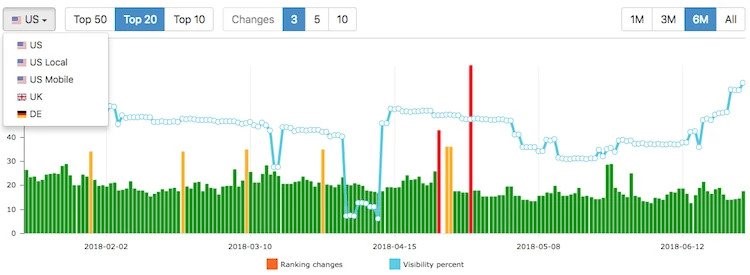

A Google a minőségi találatok biztosítása érdekében rendszeresen kiigazításokat végez az indexelést és a site-ok rangsorolását végző algoritmusai működésében. Márpedig ezek a finomhangolások iparágtól függetlenül azonnali és drasztikus változásokat okozhatnak a site-ok rangsorban felvett pozícióira nézve. Vagyis, ha a webhely szabályosan – csakis white hat módszerekkel – játszik, és technikai problémáktól is mentes, akkor megvan a megfejtés. Nagy valószínűséggel egy ilyen algoritmus-frissítés okozza a site visszaesését.

Forrás: Advanced Web Rankings

Bár a frissítések rendszeresek, nem mindegyikük kap széleskörű figyelmet. Például a Panda 4.1 és a Penguin 3.0 update bevezetését óriási érdeklődés övezte, és ezek jelentős változásokat idéztek elő. Fontos azonban látni, hogy léteznek kisebb horderejű, akár heti több alkalommal, bejelentés nélkül végrehajtott update-ek is. Az adatfrissítésnek is nevezett kiigazítások negatív hatása elleni hatékony védekezés lényegében lehetetlen. Az egyetlen járható út ilyenkor a webhely SEO-jának javítása, hogy jobb, erősebb legyen a honlap. A nagyobb, nevesített frissítések esetében, amikor a rangsorolási tényezőkön nyilvánosan változtat a Google, a rangsorolás bezuhanása megelőzhető. Mégpedig a frissítés által érintett tényezők figyelembevételével, és azok SEO stratégiába történő beépítésével.

Kétes minőségű visszamutató hivatkozások rontják a site tekintélyét

Még ha white hat technikák segítségével történik is a linképítés, akkor is becsúszhat a site linkprofiljába néhány rossz minőségű spam hivatkozás. Mit jelent ez? A spam link olyan link, amelynek a Google csekély értéket tulajdonít. (Például vagy azért, mert nem releváns site-ról, vagy mert rossz környékről érkezik stb.) Márpedig elég néhány ilyen spam link, és a Google máris rontja a webhely rangsorát. Az az eset is előfordulhat, hogy egy másik site webmesetere hivatkozik a webhelyre egy gyenge minőségű link elhelyezésével. Ilyenkor egyszerűen meg lehet kérni a hivatkozó site webmesterét, hogy vonja vissza a hivatkozást. Ugyanakkor jó szolgálatot tehet például az Open Site Explorer, vagy a Search Console disavow link funkciója. Eme eszközök segítségével könnyen eltávolíthatók a gyanús hivatkozások.Jelentős változások történnek a site backlink profiljában

Könnyen elképzelhető az az eset, hogy a site jó minőségű linkjei egyszer csak eltűnnek. Ennek oka lehet például az, hogy megszűnik a hivatkozó oldal, vagy a linkelő site webmestere eltávolítja a hivatkozásokat. Ha a webhely linkprofilja elég változatos, néhány hivatkozás eltűnése még nem okoz problémát. Ha azonban a linkek tömegesen vesznek el egyik napról a másikra, akkor a rangsorcsökkenés borítékolható.Természetesen, ha nagyon jó minőségű linkeket veszít az oldal, akár-egy két ilyen hivatkozás eltűnését is megszenvedheti a hivatkozott site. Ilyenkor ugyanis a linkkel együtt a link által a webhelynek kölcsönzött tekintély is elvész. Tegyük fel, egy oldal .edu linket szerez, de a tekintélyes domainen lévő oldal webmestere a hivatkozott oldal szempontjából rosszul dönt. Azaz például nofollow címkével látja el a linket, vagy teljesen eltávolítja azt. Ebben az esetben a hivatkozott webhely rangsorolása romlani fog, különösképpen akkor, ha új a site.

Meglepő lehet, pedig igaz, hogy a nagy tekintélyű visszamutatkozó hivatkozások megszerzése akár negatívan is befolyásolhatja a site rangsorban felvett pozícióját. Kiváltképp akkor, ha a hivatkozott oldal új (fiatalabb, mint 3 éves), nem túl tekintélyes, és kevés linkje van. Egy jelentős, pozitív irányú változás – pl. egy .edu vagy .gov domainről érkező link – rövid időre rangsorcsökkenést okozhat. Mi lehet ennek az oka? Nos a válasz a jó minőségű / rossz minőségű linkek linkprofilon belüli optimális megoszlásának környékén keresendő. Vagyis amikor egy kezdő oldal kap magas DR értékkel rendelkező hivatkozást, a Google-nek az egész rangsort újra kell számolnia. Ez pedig furcsa ingadozásokkal járhat. Az anomália egyébként néhány hét elteltével megszűnik, és természetesen megkapja a site a jól kiérdemelte helyét a SERP-listákon.

Nem gyakori, bár nem is példa nélküli a negatív SEO-támadás esete. Ilyenkor a site versenytársa vagy más rosszindulatú entitás helyez el a webhelyre mutató spam linkeket, hogy csökkentse annak tekintélyét. Annak, aki aggódik emiatt, vagy csak szeretné ellenőrizni a visszamutató profilja minőségét, érdemes kipróbálnia az ingyenes backlink-ellenőrző eszközök valamelyikét. (Bár természetesen az, aki rendelkezik aHrefs fiókkal, a Backlink Checker szolgáltatást is használhatja erre a célra.)

A tartalom minőségének romlása

Bár nem ez a leggyakoribb oka a hirtelen rangsorvesztéseknek, de még a legjobb tartalom is óhatatlanul veszít idővel a minőségéből. Könnyen elképzelhető, hogy a tartalommal (írással, publikálással stb.) kapcsolatos megközelítés megváltozása negatív irányban befolyásolhatja a site pozícióját.A Google nagyon szereti a hosszú – akár több ezer szóból álló –, részletes, hozzáadott értéket képviselő, könnyen áttekinthető, eredeti tartalmakat. Ha a site-on megjelenő anyagok kevésbé alaposak, sietősen összedobottak, nehezen átláthatók, akkor a keresőmotor nem örül. A Google ilyenkor azt hiszi, hogy ezek a tartalmak az olvasók számára kevésbé hasznosak. Ebből pedig egyenesen következik, hogy az ilyen tartalmakat publikáló oldalaknak nincs helyük a jobb pozíciók környékén.

Természetesen jó ízléssel, elmélyült módon releváns témákról írni heti vagy pláne napi rendszerességgel nem csekély kihívás. Fontos azonban látni, hogy bármilyen apró, a tartalmak megírásával, közzétételével kapcsolatos megcsúszás is okozhat átmeneti ingadozást az online rangsorokban.

Ha például olyan anyag kerül ki a honlapra, amely duplikátum, tehát megegyezik egy, a neten már közzétett tartalommal, az baj. A vétséget a keresőmotor azonnal szankcionálással honorálja, és a site-ot hátrébb sorolja. Ez nyilván azért van így, mert a cég szeretné megtartani a felhasználóit. Ezért pedig törekeszik megkímélni őket a „volt már”, vagy a „többször is volt már” nem túl izgalmas élményétől. Mindenekelőtt érdemes tehát átfésülni a webhelyeket, és kidobni a duplikált anyagokat.

A tartalmak szabálytalan időközönként történő közzététele is negatív irányban befolyásolhatja az oldal rangsorolását. Tegyük fel, hosszú időn keresztül heti három alkalommal kerül publikálásra bejegyzés egy site-on. Tegyük fel azt is, hogy ezt követően egy hónapig nem történik semmi. Ezt a változást a Google észlelni fogja, és büntetni fog miatta (ennél a pontnál bizonyulhatnak különösen hasznosnak a vendégblog szolgáltatók).

Szintén lehet némi rangsorvesztéssel számolni akkor, ha hirtelen változás áll be a tartalmak témájával kapcsolatban. Nyilván nem marad következmények nélkül, ha például a palacsinta a site-on megjelenő tartalmak témája, de egyszer csak megváltozik a fókusz. Vagyis ha hirtelen a hurkáról kezdenek szólni a posztok, a palacsinta szóra valószínűleg veszíteni fog az oldal a pozíciójából.

Hibás módosítások a robots.txt vagy a .htacces fájlban

A robots.txt és a .htacces fájlok apró módosításai nagy változásokat okozhatnak a site-ok pozícióiban. A robots.txt tartalmazza azokat az utasításokat, amelyeket a keresőrobotoknak követniük kell a webhely meglátogatásakor. A site webmestere a robots.txt-ben foglalt parancsokkal utasíthatja a robotokat, hogy hagyjanak figyelmen kívül bizonyos oldalakat, mely linkeken haladhatnak stb. Ha például „sikerül” véletlenül úgy frissíteni a robots.txt fájlt, hogy a Google oldalak tömegeit hagyja figyelmen kívül, az baj. (Ez az eset gyakrabban megesik, mint elsőre gondolná az ember). Tehát ilyenkor nyilvánvalóan jelentős teret veszít az oldal a keresőtalálati listákon. Érdemes tehát kétszer is leellenőrizni a robots.txt-ben eszközölt változtatásokat.A .htacces fájl segítségével a webhely oldalainak és bejegyzéseinek átirányítása szabályozható. A nem megfelelő beállítások következtében előfordulhat azonban, hogy 404-es hibákat vagy mindenfelé kusza átirányításokat produkál majd a site. Ha nem közvetlenül maguk a webmesterek, hanem harmadik féltől származó beépülő modul segítségével kerül szerkesztésre a fájl, érdemes résen lenni. Extrém esetben ugyanis előfordulhat, hogy a fájlt feltörik, és rosszindulatú webhelyekre mutató átirányításokat helyeznek el.

Új versenytárs felbukkanása

A helyzet az, hogy számtalan webhely törekszik a jó pozíciók megszerzésére. Márpedig ha egy új versenytárs jelenik meg a mezőnyben nagyszerű új oldallal és érdekes tartalmakkal, az megbolygathatja a status quot. Vagyis akkor az a site könnyen elorozhatja a jobb helyeket. Eközben természetesen a régi versenyzők is újíthatnak a gyakorlataikon, és vonzóbbá válhatnak a Google szemében. Ebben az esetben fokozni kell a SEO erőfeszítéseket, vagy találni egy olyan lefedetlen rést, amelyet betöltve előnyre lehet szert tenni.A verseny kiélezett – mondhatni alattomos – és még azok a cégek sem érezhetik a megszerzett

pozícióikat biztonságban, amelyek speciális termékeket, szolgáltatásokat kínálnak. Ugyanis egy nagyon hasonló profillal operáló versenytárs bármikor megjelenhet. Igaz, az első helyek megszerzése sok időbe telhet, ezért nem valószínű, hogy egy új kihívó egykönnyen az élre törhet. Ugyanakkor ez az eshetőség nem is kizárt.

Egy versenytárs-elemzés keretében azonban a helyezt és a kilátások egyszerűen tisztába tehetők. Hajtott végre valamelyik kihívó jelentős változtatásokat a honlapján a közelmúltban? Lassan, de biztosan emelkedik valamelyik honlap tekintélye a neten? Az mindenesetre biztos, hogy annak, aki szeretné megőrizni az eredményeit, több energiát kell beletennie a kihívióihoz képest az oldala optimalizálásába. Vagy, mint ahogy arról már volt szó, piaci rést találnia.

Az indexelt oldalak számának csökkenése

A Google-nek információt kell gyűjtenie az interneten lévő oldalakról, hogy a rangsorokat felállíthassa. Ha az információgyűjtési folyamat – feltérképezés – valamilyen oknál fogva problémába ütközik, megakad, a site pozíciókat veszthet.A Google webhelykeresés funkcióval ellenőrizhető, hogy a site hány oldalát indexelte a kereső. Ha csökkenés tapasztalható az indexelt oldalak számát illetően, akkor baj van.

Ideális esetben a webhely összes oldalát meglátogatják a Google robotok, hogy azok tartalmáról információkat gyűjtsenek. Ezt követően felveszik – indexelik – az oldalakat az adatbázisba, vagyis kereshetővé teszik azokat a felhasználók számára. Igen ám, de a művelet sikeres végrehajtását több tényező is akadályozhatja – vagy akár meg is hiúsíthatja. Ilyen eset lehet, amikor az oldal jelszóval védett, vagyis a botok előtt le van zárva. A 404-es hibák vagy szerverproblémák is akadályozhatják a folyamatot. Persze, az is előfordulhat, hogy az oldal túl nagy ahhoz, hogy beleférjen a robotok véges idő és erőforrás keretébe.

Bizonyos esetekben – ha a site megsérti a Google szabályzatát – előfordulhat, hogy úgynevezett manuális büntetést kap a webhely. Ennek keretében a keresőmotor deindexeli, tehát törli az adatbázisból, vagyis láthatatlanná teszi a site-ot. Ez pedig értelemszerűen lenullázza a webhely forgalmát, tehát tanácsos a Google szabályai szerint játszani. A különböző webmester eszközök is nagy segítséget jelenthetnek a térképezési és indexelési hibák detektálásában, kijavításában.

Google büntetések

A gyenge, spam jellegű honlapok kiszűrése és a minőségi site-ok favorizálása érdekében a Google fellép az irányelveit sértő webhelyekkel szemben. Azok a SEO-technikák, amelyek régebben általánosan bevett gyakorlatnak számítottak, a Google okosabbá válásának következtében ma már feketelistán szerepelnek. Ha tehát egy site ezekkel a módszerekkel operál, büntetésre – a találati listán történő hátrébb sorolásra, vagy teljes láthatatlanná tételre – számíthat, Majd pedig hosszas procedúrára, ha szeretné visszaszerezni az elvesztett pozícióit.Melyek ezek a kerülendő technikák?

- Kulcsszóhalmozás: a módszer lényege, hogy az oldal tömve van kulcsszavakkal azért, hogy minél több keresésre jelenjen meg. A technika olvashatatlan, a Google számára, vagy inkább megtévesztésére írt tartalmakat eredményez, ezért nem vezet messzire. Vagyis érdemes természetes módon beépíteni a kulcsszavakat a szövegekbe.

- Mesterséges linképítés: a linkek vásárlása, a két fél közötti linkcsere, a linkfarmok szolgáltatásaink igénybevétele láttán a Google a „szemöldökét ráncolja”. A linképítést érdemes konzervatív módon, a „kreatív”, „találékony” módszereket mellőzve elvégezni. Például vendégblog posztot írni, majd a posztrét cserébe elhelyezni az író oldalának linkjét a posztot megjelenítő oldalon. Ez az a fajta win-win megoldás, amelynek a Google is, a webmesterek is és a felhasználók is örülnek.

- Duplikált tartalom: a Google nem szereti az ismétlődő contentet. Ugyanis a felhasználói élményt rontja, ha ugyanazzal a tartalommal találkoznak a userek. Ezért nem csoda, hogy szankcionálja a módszert. Emiatt például azok az e-kereskedelmi site-ok, amelyek a termékleírásaikat közvetlenül a gyártótól másolják, bajba kerülhetnek. Érdemes ezért eredeti contentet írni, és plágiumellenőrző eszközök segítségével tesztelni még publikálás előtt a tartalmakat.

- Szűkszavú (vékony) tartalom: a keresőmotor az információgazdag contentet preferálja, tehát nem érdemes spórolni a szavakkal. Emiatt azonban azok a site-ok, amelyek hirdetések megjelenítésére szolgálnak, ritkán szerepelnek jól.

- Visszaélés a horgonyszövegekkel: korábban a kulcsszavak használata a linkek horgonyszövegében szokványos módszernek számított SEO szakértő körökben. A 2012-es Penguin Frissítésnek köszönhetően azonban ez a gyakorlat ma már nem javasolt. Érdemes tehát a horgonyszövegeknek természetes, valódi kifejezéseket tartalmazniuk.

A véletlen, mint a Google szeszélye

A site-ok hirtelen bezuhanása esetén sajnos a véletlennel mint rangsorolási tényezővel is számolni kell. A Google Dance-nek nevezett jelenség azokra a megmagyarázhatatlan rangsorváltozásokra utal, amikor véletlenszerűen megkeverednek a site-ok pozíciói. A Google szeszélyének következményei szerencsére nem véglegesek. Tehát ha a helyezések azért borultak meg, mert a keresőmotornak „rossz napja van”, nincs nagy gond. Előbb-utóbb a rangsor visszatér az normális kerékvágásba.A fentiek alapján jól látható, hogy számos tényező szerepet játszhat a webhelyek pozícióinak egyik napról a másikra történő bezuhanásában. Akár szerverproblémák, akár algoritmus-frissítések, akár a Google büntetései okozzák a problémákat, először mindenképpen azonosítani kell a bajok forrását. Majd a diagnózis alapján elvégezni a szükséges ellenintézkedéseket. Ha támogatásra van szüksége, és szeretné megtudni, miért esett vissza a honlapja helyezése, egy SEO-audit segíthet feltárni a problémákat. Így pedig könnyen visszaszerezheti az elvesztett pozícióit.